Malé jazykové modely na vlastním serveru: kdy dávají smysl a jak je nasadit

Malé jazykové modely se stávají praktickou alternativou k velkým cloudovým LLM. Umožňují firmám nasadit umělou inteligenci (AI) přímo na vlastním serveru, mít kontrolu nad daty, snížit náklady a zároveň získat dostatečně chytré nástroje pro konkrétní úlohy. Podíváme se, kdy to dává smysl, jaké scénáře jsou pro malé modely ideální a jak je v praxi nasadit.

Co jsou malé jazykové modely a jak se liší od LLM

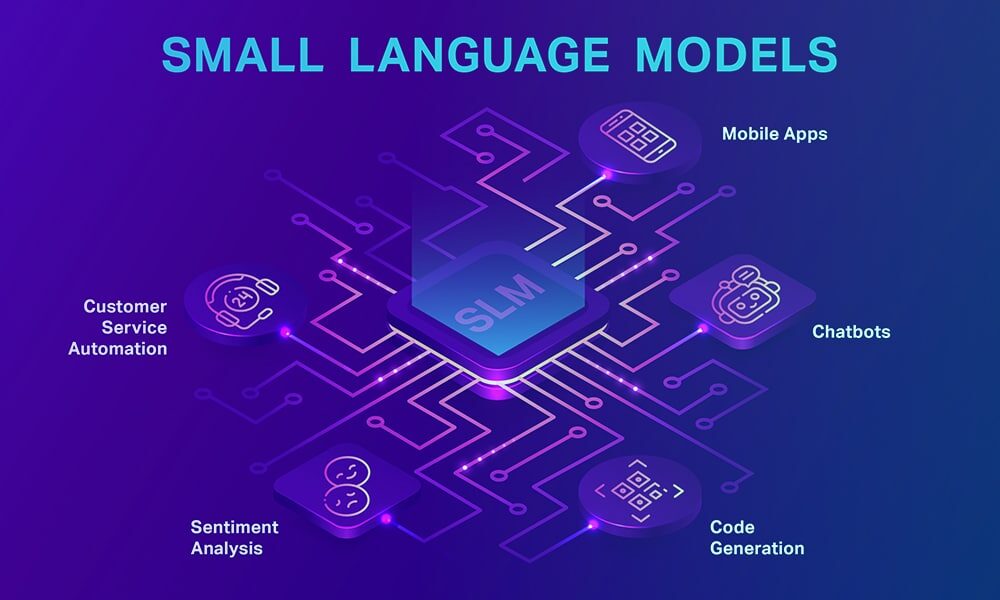

Malé jazykové modely (v angličtině Small Language Models, SLM) jsou odvozené od známých velkých modelů (LLM), ale s podstatně menším počtem parametrů – typicky od stovek milionů do několika miliard parametrů. Díky tomu mají výrazně nižší výpočetní a hardwarové nároky a rychlejší odezvu. To z nich dělá ideální kandidáty pro lokální nasazení mimo cloud, píše Microsoft.

Z praktického pohledu platí:

- LLM – maximální výkon, široké znalosti, ale vysoké nároky a často cloudový provoz.

- SLM – menší, úspornější, ideální pro konkrétní firemní úlohy (summarizace, klasifikace textu, interní chatbot, práce s dokumenty).

Menší modely mají obvykle omezenější univerzální inteligenci, ale pro jasně definované úkoly poskytují dostatečnou kvalitu. Navíc přinášejí benefity v podobě nižší latence, lepší kontroly nad daty a jednoduššího nasazení do firemního prostředí.

Typickými příklady moderních SLM jsou například Mistral 7B, LLaMA 3 8B, Microsoft Phi nebo Google Gemma. Modely navržené tak, aby nabídly dobrý výkon bez extrémních hardwarových nároků.

Jak se přesně SLM liší od velkých jazykových modelů

- Rozsah znalostí – velké jazykové modely zvládají široké spektrum úloh a mají vysokou obecnou inteligenci. SLM jsou omezenější, ale pro konkrétní firemní scénáře často úplně stačí a lze je dobře přizpůsobit jednomu zaměření.

- Výpočetní nároky – LLM potřebují výkonné GPU, drahou infrastrukturu a typicky cloudový provoz. SLM běží na běžnějších GPU, lze je kvantizovat a provozovat přímo na vlastním serveru.

- Rychlost a latence – menší modely reagují rychleji a jsou vhodné pro aplikace v reálném čase (interní chatboty, sumarizace a klasifikace).

- Bezpečnost dat – lokální SLM znamenají, že data neopouštějí firmu, snáze se splňuje GDPR a snižují se právní i bezpečnostní rizika.

- Zaměření na úkol – zatímco velké modely jsou univerzální nástroje pro téměř jakýkoliv typ úlohy, malé modely cílí na konkrétní praktické použití. Vynikají při sumarizaci, třídění a práci s firemními dokumenty, ale u kreativních a složitých problémů stále převažují výhody velkých LLM.

Proč provozovat modely „on-premise“

Pro mnoho firem není otázkou, zda AI používat, ale jakým způsobem ji provozovat. A právě malé jazykové modely nasazené přímo „on-premise“, tedy ve vlastní infrastruktuře, přinášejí několik zásadních výhod:

- Ochrana dat a legislativa – lokální provoz AI zajišťuje, že citlivá data neopouštějí organizaci, což usnadňuje splnění GDPR a snižuje bezpečnostní rizika. V některých oblastech, jako je zdravotnictví, armáda nebo státní správa, je navíc provoz AI mimo veřejný cloud často nutnou podmínkou.

- Kontrola a přizpůsobení – na vlastním serveru máte plnou kontrolu nad verzemi modelů, jejich tréninkem i aktualizacemi. To je klíčové například tam, kde modely odpovídají na firemní interní dotazy, musí respektovat firemní terminologii či bezpečnostní pravidla.

- Nižší dlouhodobé náklady – u velkého počtu dotazů nebo trvalého využití AI může být cloudové API dražší než investice do vlastního HW a provozu modelů. To platí obzvlášť pro menší modely, které nepotřebují výkonné GPU jako LLM.

- Nízká latence – když model běží přímo na lokálním HW, odpovědi jsou okamžité bez potřeby síťových dotazů mimo vaši infrastrukturu. To je výhoda pro realtime aplikace a interní systémy.

Jak malý model na svém serveru nasadit krok za krokem

1) Vyberte správný model – vyhledejte open-source SLM vhodný pro vaši úlohu. Knihovny jako Hugging Face Transformers nabízejí mnoho předtrénovaných verzí (např. modely s řádem stovek milionů parametrů).

2) Připravte hardware – i malé modely profitují z GPU s dostatečnou VRAM, ale jejich nároky jsou výrazně nižší než u LLM. Některé lze provozovat i na běžných VPS s GPU.

3) Nainstalujte inference engine – software jako TensorRT, ONNX Runtime, TorchServe nebo NVIDIA Triton pomůže efektivně spouštět modely a škálovat jejich odezvu dle zatížení.

4) Data a bezpečnost – zajistěte šifrování, audit přístupů a pravidla pro aktualizaci modelů i bezpečné ukládání tréninkových dat.

5) Monitorujte výkon – sledujte latenci, přesnost výstupů a využití HW. U SLM je totiž snazší optimalizovat inferenci než u velkých modelů.

Vhodná infrastruktura jako základ lokální AI

Malé jazykové modely ukazují, že AI nemusí znamenat jen závislost na velkých cloudech a vysokých nákladech. Nabízejí realistickou rovnováhu mezi výkonem, bezpečností, rychlostí a ekonomickou efektivitou. Pro firmy, které chtějí využít umělou inteligenci prakticky, a přitom mít kontrolu nad daty i technologiemi, představují SLM velmi atraktivní cestu.

Klíčové přitom je mít k dispozici vhodnou infrastrukturu. Lokální nebo „on-premise“ provoz malých modelů lze dnes řešit i formou privátního cloudu, který kombinuje výhody vlastního prostředí s flexibilitou profesionálního hostingu.

Právě takové zázemí nabízí například ZonerCloud, který umožňuje provoz AI modelů na výkonných serverech v českém datacentru, s důrazem na bezpečnost, datovou suverenitu a předvídatelné náklady.

V praxi tak firmy nemusí volit mezi vlastním serverem a globálním cloudem. Malé jazykové modely lze provozovat i na lokální cloudové infrastruktuře, která splňuje technické i legislativní požadavky moderního využití AI.